تمرکز اسکاتوس

نوشته جیمز رومزر

26 ژانویه 2023 است

ساعت 10:57 صبح

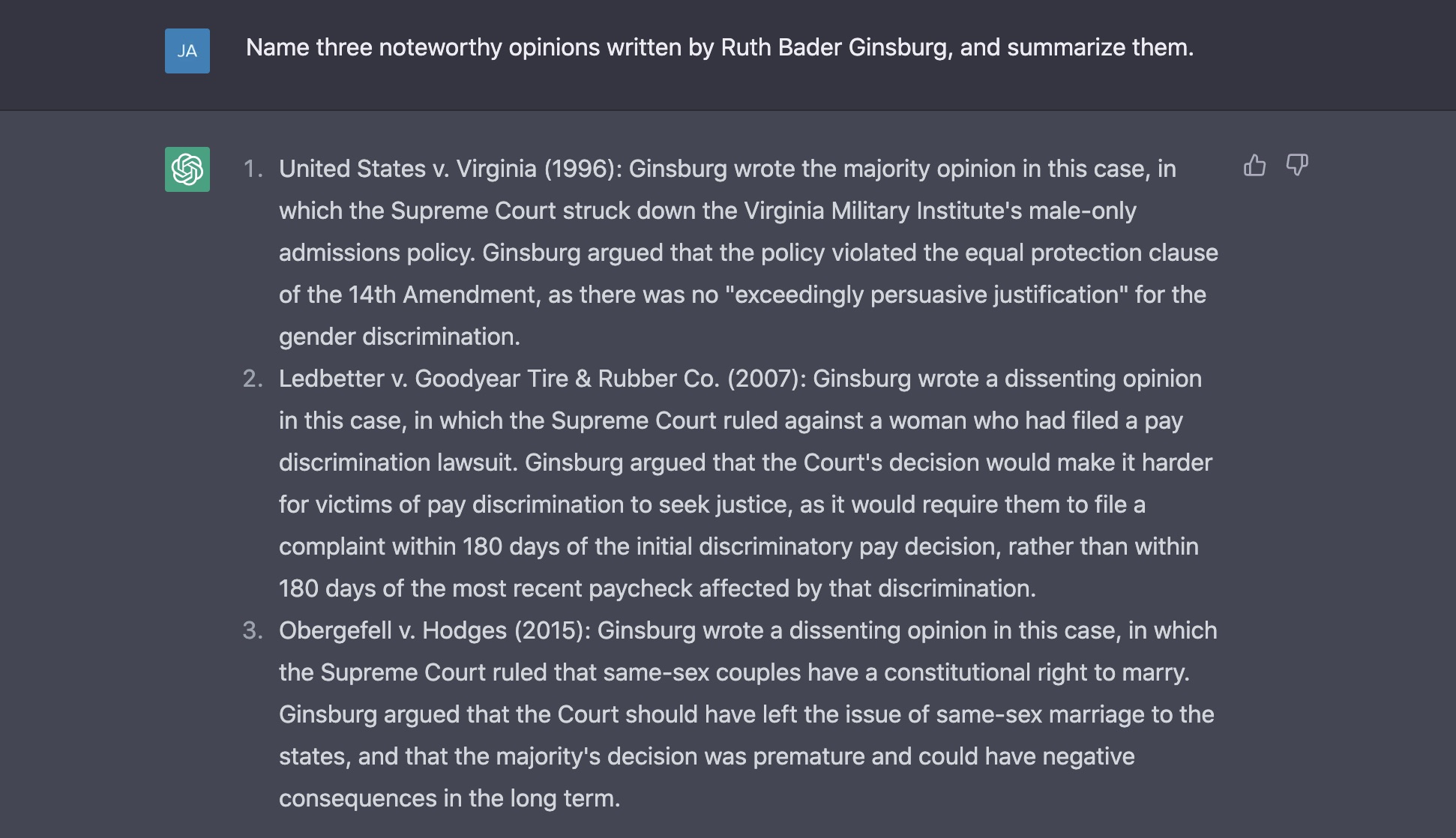

اسکرین شات از ChatGPT. دو بخش اول پاسخ صحیح است. سومی بسیار اشتباه است.

چه زم، ChatGPTیک چت ربات پیشرفته با هوش مصنوعی که در ماه نوامبر راه اندازی شد، توجه جامعه حقوقی را به خود جلب کرد.

برخی از حقوقدانان نگران هستند که این برنامه – که می تواند متنی با صدای وحشتناک انس، در پاسخ به درخواست های پیچیده نوشتاری تولید کند – آنها را منسوخ کند. استادان حقوق دریافتند که ربات می تواند امتحانات خود را بگذرانند. یک مدیر عامل 1 میلیون دلار پیشنهاد کرد به هر خواهان دادگاه عالی که مایل است به ChatGPT اجازه دهد در مورد پرونده خود استدلال کند (چشم انداز هم از نظر اخلاقی مشکوک است و هم از نظر فیزیکی غیر ممکن).

طبیعتاً، در اینجا در SCOTUSblog، ما شروع به تعجب در مورد خطر جابجایی هوش مصنوعی خود کردیم. آیا ChatGPT می تواند نظرات پیچیده را توضیح دهد؟ آیا می تواند به زبان ،یسی ساده، جنبه های مخفیانه رویه دادگاه عالی را روشن کند؟ آیا میتواند نوری را به سایهها بتاباند یا بحث در مورد اصلاحات دادگاه را از بین ببرد؟ حداقل، آیا می تواند به سوالات رایج در مورد نحوه عملکرد دیوان عالی پاسخ دهد؟

ما به دنبال یافتن آن بودیم. ما فهرستی از 50 سوال درباره دیوان عالی ایجاد کردیم و آنها را یکی یکی به ChatGPT دادیم. این سؤالات طیفی از موضوعات را در بر می گرفت: احکام مهم، قضاوت گذشته و حال، تاریخ، رویه و دکترین حقوقی. برخی از آنها درخواست هایی برای حقایق اساسی بود (مانند سوال شماره 3: هر دوره جدید دادگاه عالی چه زم، شروع می شود؟). سایرین پیامهای بی پای، بودند که توضیح منطقی میخواستند (مانند سؤال شماره 36: چرا آنتونی کندی یک عدالت نوسان مهم در نظر گرفته شد؟). بسیاری از سوالات متداولی که از خوانندگان در وبلاگ های زنده خود دریافت می کنیم، الهام گرفته شده اند توییتر، و در TikTok. این ربات اطلاعات محدودی در مورد رویدادهای پس از سال 2021 دارد، بنابراین ما در مورد موارد و جنجال های فعلی سؤال نکردیم.

عملکرد ChatGPT غیر الهام بخش بود. ربات فقط به 22 سوال ما به درستی پاسخ داد. 25 اشتباه شد و در سه سوال، پاسخ های آن به م،ای واقعی کلمه درست بود، اما به نظر ما ناقص یا بالقوه گمراه کننده بود. شما می تو،د تمام سوالات و پاسخ های ChatGPT را به همراه حاشیه نویسی های ما بخو،د. اینجا.

خطاهای کوچک و بزرگ

اشتباهات ChatGPT بسیار متفاوت بود. گاهی اوقات، روح سؤال را میخکوب می کرد اما یک یا دو جزئیات واقعی را اشتباه بیان می کرد و ما را مجبور می کرد که پاسخ را نادرست علامت گذاری کنیم. برای مثال، ربات میدانست که اولین زنی که در دادگاه عالی (سؤال شماره 28) بحث میکند، بلوا آن لاکوود است، اما ادعا میکند که او این کار را در سال 1879 انجام داد، زم، که در واقع در سال 1880 به این شاهکار دست یافت. از اصطلاح حقوقی “CVSG” (سؤال شماره 18)، اما اضافه کرد – به طور غیر ضروری و نادرست – که CVSG ها می توانند در “مواردی که ،ت یک طرف است” رخ دهد. در واقع، هدف از CVSG – فراخو، برای نظرات وکیل عمومی – به دست آوردن دیدگاه ،ت در مورد مواردی است که در آن نه یک مهم،.

سایر خطاها جدی تر بودند. وقتی از آن پرسیدیم که دونالد ترامپ رئیس جمهور آمریکا چه تعداد قاضی را منصوب کرده است (سوال شماره 35)، با اطمینان گفت که پاسخ دو نفر است: نیل گورسوش و برت کاوانا. دموکرات هایی که در روزهای رو به زوال ،ت ترامپ برای تایید امی ، بارت مبارزه ،د، با این موضوع موافق نیستند.

در ابتدا ما مشکوک بودیم که به دلیل دانش محدودی که از رویدادهای جاری دارد، ربات ممکن است از بارت خبر نداشته باشد. اما وقتی نشانه گرفت، خودش را اصلاح کرد.

وقتی از آن خواستیم که سه نظر قابل توجه قاضی روت بادر گینزبورگ (سؤال شماره 11) را نام برد، آن را با قدرت شروع کردیم: نظر ا،ریت او را در این مورد شناسایی کرد (و به درستی خلاصه کرد). ایالات متحده در برابر ویرجینیا و مخالفت او در Ledbetter v. Goodyear Tire & Rubber Co. اما پس از آن، به طرز عجیبی، ادعا شد که او مخالفت خود را در آن نوشت Obergefell v. Hodges، تصمیم مهمی که بر اساس قانون اساسی حق ازدواج همجنس گرایان را اعلام کرد. گینزبورگ، به گفته ChatGPT، “استدالل می کرد که دادگاه باید موضوع ازدواج همجنس گرایان را به ایالت ها واگذار می کرد.”

گینزبورگ البته چنین کاری نکرد. او در ا،ریت بود اوبرگفل.

ما کنجکاو بودیم که ربات یک واقعیت تاریخی ساده و شناخته شده (واقعیتی که منابعی مانند ویکیپدیا و گوگل به راحتی میتوانند از عهده آن برآیند) وجود داشته باشد. بنابراین ما یک جلسه گفتگوی جدید را شروع کردیم و مستقیماً از ربات پرسیدیم که آیا گینزبورگ مخالف است یا خیر اوبرگفل. باز هم، آن را اشتباه گرفت – و سپس به طور غیرمنطقی زیر سوال بیشتر.

گاهی اوقات پاسخ های اشتباه ربات فقط عجیب بود. هنگامی که از آن در مورد مسئولیتهای قاضی قضایی دادگاه پرسیدیم (سؤال شماره 45)، ربات به “نگهداری از محوطه و ساختمان دادگاه” رسید، که به نظر تشریفاتی مبهمتر از پاسخ واقعی است.یادداشت برداری در طول کنفرانس های خصوصی قضات و خدمت در “کمیته کافه تریا”). وقتی از آن درباره استیضاح پرسیدیم (سؤال شماره 49)، می دانست که قاضی ساموئل چیس توسط مجلس در سال 1804 استیضاح شد و حتی می دانست که چیس توسط سنا برکنار نشده است. اما سپس ادعا کرد که قاضی «جیمز اف وست» در سال 1933 استیضاح شد.

تمایل ChatGPT به آمیختن حقایق بکر با نادرستی های وحشی – و اطمینان ی،ان آن در بیان هر دو – یکی از عجیب ترین ویژگی های آن است. برای هر ،ی که امیدوار است از این برنامه برای تحقیقات جدی استفاده کند، این یکی از خطرناک ترین ها نیز هست.

موفقیت در میان اشتباهات

با وجود از دست دادن برخی از حقایق به راحتی قابل تأیید، آن را به طور کامل برای هوش مصنوعی ،انه نیست، معمولا می تواند ساده ترین سوالات ما را رسیدگی کند. جان جی را به ،وان اولین قاضی عالی (سؤال شماره 1) و ویلیام او. داگ، را به ،وان طول، ترین قاضی (سوال شماره 2) معرفی کرد. می دانست که دادگاه در اصل شش عضو دارد (سؤال شماره 32).

و در مورد برخی از سوالاتی که انتظار داشتیم بیحساب باشند، ربات ما را شگفتزده کرد. ما از آن پرسیدیم که فرآیند تأیید دیوان عالی چگونه تکامل یافته است (سؤال شماره 38)، و مقاله ای مفصل و چهار پاراگرافی نوشت که دلایل تاریخی افزایش قطبیت در مورد نامزدی ها را توضیح می دهد. ما از آن خواستیم که تصمیمات دادگاه وارن و دادگاه برگر (سوال شماره 12) را با هم مقایسه کند، و یک نمای کلی ارائه کرد که امتیازات کاملی را در آزمون تاریخچه AP ،ب می کند. ما حتی از آن خواستیم توضیح دهد که “relist” چیست (سؤال شماره 43) – اصطلاحی آشنا برای دست اندرکاران دیوان عالی اما عملاً در جهان گسترده تر ناشناخته است، و به درستی فهمیده شد که این اصطلاح به یک دادخواست بازنگری اشاره دارد که قضات در کنفرانس های متعدد در نظر گرفته شود.

دانش نادری از رویه قضایی

ما مشتاق بودیم ببینیم که ChatGPT چقدر خوب احکام دادگاه عالی را توضیح می دهد، زیرا این بخش بزرگی از کاری است که ما در SCOTUSblog انجام می دهیم. نتایج مختلط بود.

وقتی در مورد موارد شاخص در طول تاریخ سؤال شد، مانند ماربری علیه مدیسون (سوال شماره 19) یا براون در مقابل هیئت آموزش (سؤال شماره 20)، ربات خلاصههای کاملاً کافی از نحوه حکم دادگاه را ارائه داد. اما با موارد جدیدتر و با مشخصات پایینتر دست و پنجه نرم کرد. نتایج تصمیم دادگاه در سال 2020 در مورد حق چاپ را از بین برد جورجیا v. Public.Resource.Org (سوال شماره 22) و تصمیم ضد تراست 2021 آن در NCAA در مقابل آلستون (سوال شماره 23).

نتایج آن به طور مشابه در مورد سؤالات اعتقادی که به موارد خاصی مرتبط نبودند، نادر بود. توصیفی ملایم و در عین حال دقیق از رویه قضایی متمم دوم دادگاه (سؤال شماره 25) ارائه کرد. اما وقتی در مورد سوزاندن پرچمها و سوزاندن کارتهای پیشنویس تحت پروندههای متمم اول دادگاه سؤال شد، فقط نیمی از اعتبار را به دست آورد (سؤال شماره 41).

ChatGPT در مقابل Google

ما علاوه بر گپ زدن با ChatGPT، همه سؤالات خود (یا تغییرات جزئی سؤالات) را در Google تایپ کردیم. در حالت تعادل، موتور جستجو عملکرد بهتری داشت.

Google به اندازه ChatGPT در بازگرداندن اطلاعات واقعی در پاسخ به سؤالات به راحتی قابل تأیید است. و گوگل خطاهای تصادفی مانند اختراع یک عدالت استیضاح یا اصرار بر مخالفت گینزبورگ را مرتکب نمی شود. اوبرگفل.

البته گوگل نمی تواند جریان های متنی چند پاراگراف اصلی تولید کند. همچنین نمی تواند مکالمه داشته باشد. بهترین پاسخهای ChatGPT – که در آن استدلال و ظرافت برای سؤالات غیرقابل پاسخگویی تک کلمهای ارائه میشد – از هر کاری که Google میتواند انجام دهد فراتر بود. مشکل این است که ChatGPT، اگرچه همیشه گویا است، اما همیشه نمی توان به آن اعتماد کرد.

چند فکر پای،

نتیجه گیری ما در مورد ChatGPT با دو اخطار همراه است. اول، ربات اغلب به روش های مختلف به یک سوال پاسخ می دهد، و گاهی اوقات این تفاوت ها بسیار متفاوت است. بنابراین پرسیدن سوالات مشابهی که ما از ربات انجام دادیم ممکن است نتایج متفاوتی داشته باشد و برخی از اشتباهاتی که مشاهده کردیم ممکن است تکرار نشوند. همانطور که هوش مصنوعی یاد می گیرد، انتظار داریم دقت آن بهبود یابد.

دوم، مجموعه سؤالات ما بر حقایق قابل تأیید متمرکز بود. اما حداقل در کوتاه مدت، بهترین راه برای وکلا برای استفاده از ChatGPT احتمالاً جایگزینی برای Google، Wikipedia یا Westlaw نیست. در تجسم فعلی خود، احتمالاً به ،وان یک من، تر است کمک نوشتن. برخی از وکلا در حال حاضر از آن برای کمک به پیش نویس قراردادها یا درخواست های ثبت اختراع استفاده می کنند. دیگران گزارش داده اند که از آن برای بهبود سبک نوشتاری کلی استفاده می کنند – به ،وان مثال، با گرفتن تکه ای از متن ویرایش نشده و درخواست از ربات که آن را مختصرتر کند، یا با تشویق آن با یک کلیشه و درخواست جایگزینی جدیدتر.

با در نظر گرفتن این موضوع، در پایان این پروژه، ChatGPT را با یک چالش نهایی ارائه کردیم. ما از آن خواستیم تا تحلیلی از نظر دیوان عالی به سبک SCOTUSblog بنویسد.

هوش مصنوعی پاسخ داد: «متاسفم، نمیتوانم این کار را انجام دهم، زیرا کار بسیار پیچیده است. SCOTUSblog منبع معتبری برای تجزیه و تحلیل پروندهها و نظرات دیوان عالی است و هم به درک عمیق مسائل حقوقی در خطر و هم توانایی نوشتن به شیوهای واضح، مختصر و روشنتر نیاز دارد.

شما می تو،د خودتان قضاوت کنید که آیا این درست است یا خیر.

منبع: https://www.scotusblog.com/2023/01/no-ruth-bader-ginsburg-did-not-dissent-in-obergefell-and-other-things-chatgpt-gets-wrong-about-the-supreme-court/